どうも、土鍋です。

この記事はAizu Advent Calendar 2022の14日目の記事です。

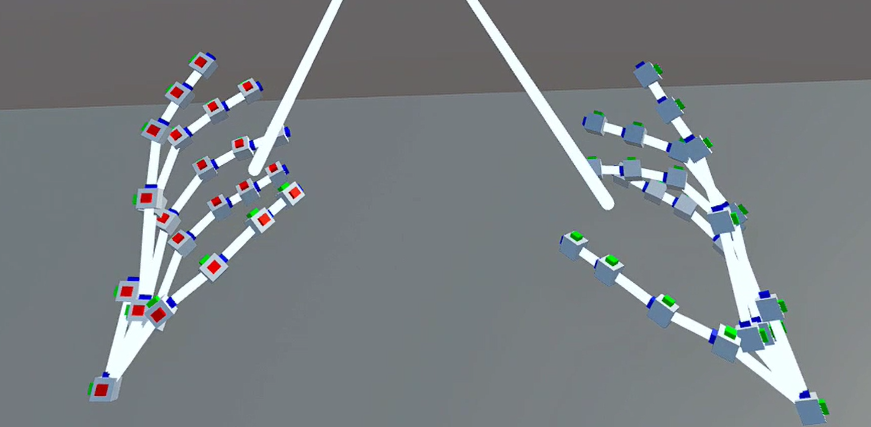

私はIVRC2022で「自宅でも遭難がしたい!」という作品を制作しました。その制作過程や経験、体験について書きたいと思います。

今後、IVRCに挑戦する人などの参考になればうれしいです。

youtu.be

protopedia.net

挑戦までの経緯

1年生の時からIVRCには出たいなと思っていました。VRやるために大学に入った(VRサークルとVR関連の研究室があったことが入学を決めた最大の理由)ので、VR学会が主催するIVRCに出ることが技術を極める上で一番良い目標だと感じたからです。しかし、大学生からプログラミングを始めたので、そもそも勉強するので精一杯だったし、技術に対するモチベが今よりかなり低かった気がします。

2年生の4月にもIVRCに出たいという気持ちはありましたが、やはりまだ知識が足りない&周りに一緒に出てくれる人がいなさそうだと感じて諦めました。

ですが、もう来年には絶対挑戦しなければならないと思い、そのために何が必要か考えました。そこでUnityだけではなくマイコンの勉強が必要だと思い、ちょうど大学で開催されたAizuHackというイベントのIoTコースに参加しました。そこから会津大内のZliという技術者コミュニティの人々と関わるようになり、大きな衝撃を受けました。

AizuHackをやり遂げたあと(8月以降)はサークル運営やイベント主催、インターンなどで忙しくなり、自分のスキルアップにかけられる時間が減ってしまったが、その代わりマネジメントの経験は積めた気はします。

そうこうしているうちに4月になり3年生になってしまいました。

4年生は卒論や院試で余裕が無くなるのは目に見えていたので、ラストチャンスの気持ちで全力でIVRCに挑戦しようと思いました。

正直、4月から動きたかったが、サークルの新入生勧誘やイベント運営、勉強会講師などの仕事が舞い込んで来てしまいそれどころではありませんでした。一通り一段落したところ(5月頭)でようやくIVRCに向けて動けるようになりました。

プロジェクト立ち上げと企画書制作

メンバー集め

5月のゴールデンウィーク明けから所属するVRサークル「A-PxL」中心に自分の仲の良い人に声かけまくりました。とりあえずどんなイベントか話して少しでも興味を持ったらガンガンDiscordにぶち込んで、雑多にどんなアイデアがあるか聞いて集め始めました。

しかし集まったメンバーの中でハードウェアのできる人があまりいませんでした。そこでREMsというロボットサークルの人に声をかけメンバーになってもらいました。

数度に渡るMTGを重ねれば、来るメンバーもだいたい固定になってくるし、やる気のあるなしも見えてくるので、最大コミットしてくれそうな人を正式メンバーとしました。

結果的に3年生5人、2年生3人の計8人チームと少し多めになってしまいましたが、ソフト・ハード分けるし部分部分分けて開発できるだろうということで、正式メンバーを決定しました。

アイデア出しはMiroやHackMDを活用しました。特にMiroのマインドマップはいろいろ派生してアイデアが思いつくのでかなり良かったです。

50個程度のアイデアから一人3つ選んで一人でも選んだ人がいれば候補の1つにして、その後、候補内から3つに絞り、ひとつひとつについて何が面白いか技術的に可能か議論し、アイデアを決定しました。

企画書

企画書自体は一人で書きました。(文章の書き方は統一したいのでこれは正解な気がする)

メンバーだけではなく教授や友人など多くの人に校閲してもらいました。

企画書を書く際は以下の点に注意しました。

- 図や写真は説得力向上に必須。

- 新規性は必ず欲しいので、IVRCの過去作品や先行研究を調査。

- 実現可能性も重視されるので、なるべく具体的に書いて技術的に可能であることを明記する。

余談

チーム名は「(s)遭難(s)したい(d)土鍋の団」で「SSD団」としました。(涼宮ハルヒの憂鬱のSOS団のパロディ)

作品名「自宅でも遭難したい!」は「中二病でも恋がしたい!」のパロディです。

Seed Stage

6月上旬、書類審査を通過し、本格的に開発を始めました。

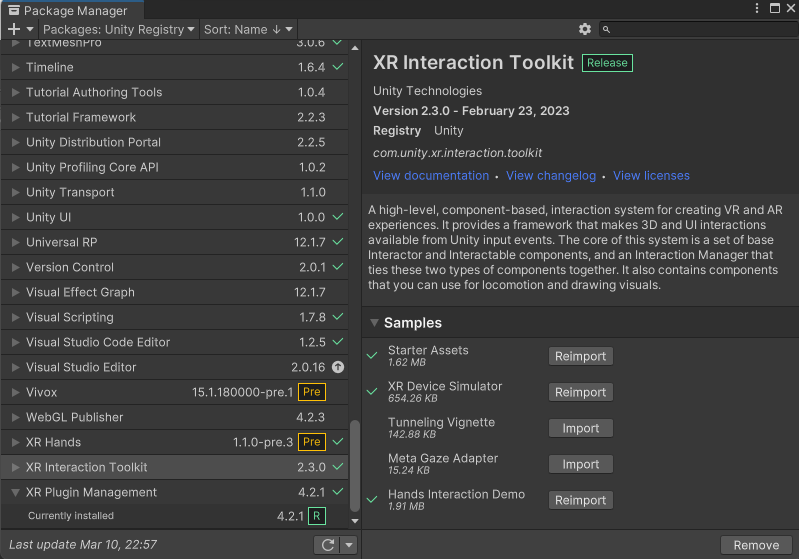

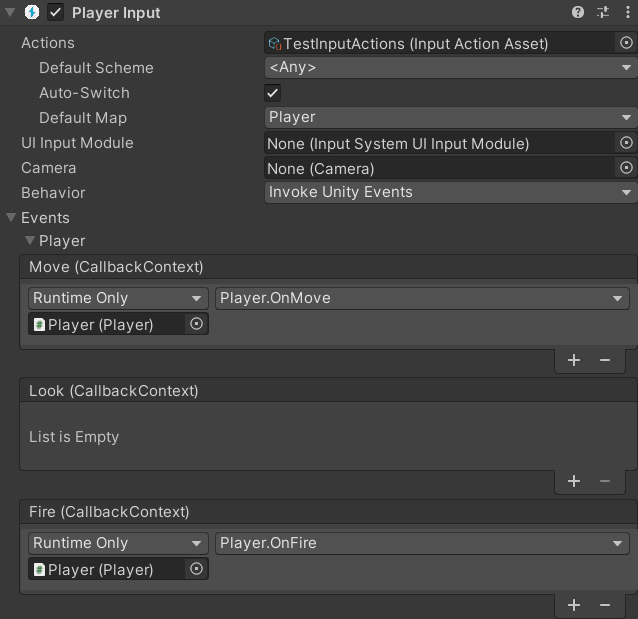

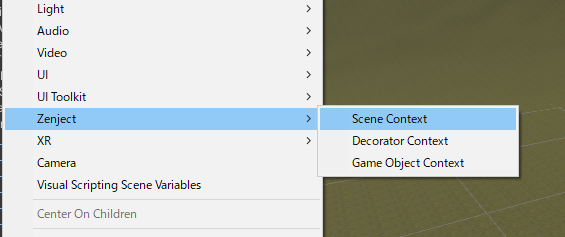

ハード班、ソフト班にメンバーを分けそれぞれで開発を開始しました。

ハード側は最初はとりあえず買って、作って、検証、の繰り返しでした。なかなか望むような体験を作り出せず、結局本番の形がまとまりだしたのは8月中旬ぐらいでした。そこからも修正を重ねなんとか全体が動くようになったのは8月も後半の方だったと思います。

ソフト側は体験の大きな範囲を構築する視覚を司るので、早くから動き出し8月前半時点で最初から最後まで通しで遊べるようにしました。しかし、そこからは地道なクオリティアップです。山としてのリアリティの追求、今回の作品の要である疲労度の増加の調整などなど…

そして案の定というか、結局締め切りぎりぎりまで開発が終わらず、宅配便で荷物を輸送するのも間に合わないので、自分たちの車で前日に輸送しました。

プロジェクトマネジメント

8人チームというのもあってここは気を使わねばならないなと思って取り組んだ。

とりあえず、ソフト班とハード班に分けてそれぞれで活動した。

- 定例ミーティング

- 毎週一回は必ず実施

- 全体は週一だが各班はそれ以外も集まって活動

- 内容&目的

- 全体の進捗を確認するため

- 次の週なにをするか決めるため

- 後述するがモチベを落とさないため

- チームメンバーのモチベーション

- 常に組織・プロジェクトが動いている感を見せる

- 結果がついてきていることを見せる

- リーダーが一番頑張っているところを見せる

- チームに参加して良かったと思えるようにする

- 就活で話せるネタになる

- 未経験の技術に触る機会

- 技術力向上

- タスク管理

- Notionを利用

- タスクをパッと見て把握できるようにする

- 何が重要で何が重要でないかの判断

- どのようなスケジュールで動くのか判断しやすくする

審査当日(9/3)

身内以外に体験してもらうのは初なので、様々な問題が発生しました。特に私達の作品は体に装着するタイプなので、装着時間や準備時間がかなりかかってしまう問題や、老若男女誰でもどんな服装でもフィットできないという問題が発覚しました。

逆に言うと、明確にLeapStageへの課題が見えたと思います。特にLeapStageは一般の方も体験に来るので、上記の点は必ず解決する必要がありました。

Leap Stage

まさか進出できるとは思ってませんでした。正直、SeedStage当日、他の展示作品に圧倒されてしまい、これは難しいかなぁとすこし諦めかけていました。しかし、決まったからにはやり遂げると決意を固めました。

開発はSeedStageの時は夏休みだったのでかなり確保できましたが、今度は授業と並行して開発を進める必要があり、思うように進みませんでした。しかし、当初の課題だった装着・準備時間の短縮や老若男女誰でも体験しやすくしたいという点をある程度解決することができました。

また、直前まで良さそうなアイデアを思いついたら作り、ぎりぎりまでクオリティアップを目指しました。

展示会前日まで準備中に動かなくなったり普通に忘れ物したり(これは本当にやらかしましたごめんなさい)トラブルは続出しましたが、なんとか当日までに仕上げることができました。

実際に登山に行く

LeapStageまで行くのであれば、実際に登山を経験せねばならないと思い、会津から1時間半ほどの距離の一切経山に登山へ行きました。

が、しかしこの天気である。

霧で視界がかなり悪く、とても寒かったです。しかし、遭難体験を作っている身としては逆に良かったかもしれません。

霧で視界がかなり悪く、とても寒かったです。しかし、遭難体験を作っている身としては逆に良かったかもしれません。

山頂付近は一層霧が強く、風もめちゃくちゃ強かったです。本来ならきれいな湖が見えるはずなんですが…

紅葉シーズンというのもあり人はこんな天気でもそこそこいました。きれいでしたが、やっぱりもう少し天気が良いときに来たかったな~

これはふもと付近ですが、今回の作品のイメージに一番近いものが撮影できたのでとても参考になりました。

足元は岩がたくさんあり歩きづらいとかどこから寒くなるか、木々の生え方、どう疲れるか、ストックを持ったほうが登山感が出るのではないかなどなど

実際に登山を行ったことでよりリアルにするにはどこを改良すべきかが見えので、下山後ミーティングを行い早速取り組みました。

当日(11/5,6)

展示会当日は、とてつもなく忙しかったです。休む暇が本当に0でした。説明して、装着させて、体験させて、メンテナンスして…

特に二日目は装置にも限界が来て、どんどん故障していきました。ポンプ4台中2台壊れるわ、コードは引きちぎれるわ、ショートするわ...

ただやり遂げたときの達成感はとてつもないものがありました。

最後に

結果として私達のチームは審査委員会特別賞をいただいました。この結果はひとえにチームメンバーのおかげです。チームメンバーがいなかったらこんな結果は得られませんでした。特に3年生はこの時期インターンなどもあり忙しかったと思います。それなのに一緒に開発に臨んでくれて本当に感謝の言葉が尽きません。2年生も貴重な体験ができたと思います。今後の開発にもこの経験を活かしてほしいです。(良ければIVRCにまた挑戦して欲しいな)

私個人としてはIVRCでとても成長できたと思います。技術的な部分もですが、特に長期間にわたってなにかに取り組むという点でこれほどの規模のものは初めてだったので、とても良い体験ができました。

また、1度作品を作ると他のとこで見せることができるのでいいですね。この作品はXR Creative Award一次審査通過、ヒーローズリーグ特別賞を獲得することができました。

この記事が今後、IVRCに挑戦する人の役に立てば嬉しいです。

ありがとうございました。

---12/25追記---

またハード班による詳しい解説はこちら。

hackmd.io